Die rasante Entwicklung der Künstlichen Intelligenz (KI) wirft wichtige ethische Fragen auf, die eine Neuauslegung der klassischen Robotergesetze erfordern. Isaac Asimovs Drei Gesetze der Robotik, eingeführt 1942, sind nach wie vor ein bedeutender Bezugspunkt in der Diskussion über die Verantwortlichkeit und Sicherheit von KI-Systemen. Diese Gesetze, die darauf abzielen, das Wohl der Menschheit zu sichern und schädliche Handlungen von Robotern zu verhindern, müssen jedoch angesichts der heutigen Herausforderungen, wie autonome Fahrzeuge und KI im Gesundheitswesen, kritisch überdacht und angepasst werden. Der vorliegende Artikel beleuchtet sowohl die Relevanz der ursprünglichen Gesetze als auch die Notwendigkeit für ein Update, um sicherzustellen, dass ethische Prinzipien in die Entwicklung und den Einsatz von KI integriert werden.

Die Herausforderungen der Einhaltung ethischer Prinzipien in einer KI-gesteuerten Welt

In der heutigen technologischen Landschaft könnte man provokant behaupten, dass die Grundprinzipien der Robotik und die ethischen Rahmenbedingungen für Künstliche Intelligenz möglicherweise in naher Zukunft überholt sein werden. Während Isaac Asimovs Drei Gesetze der Robotik als fundamentales Regelwerk für den Umgang mit intelligenten Maschinen konzipiert wurden, stehen sie vor der Herausforderung, mit einer Technologie Schritt zu halten, die sich exponential entwickelt. Die klassische Vorstellung, dass Maschinen vor allem dem Menschen dienen und dabei nicht Schaden verursachen sollen, wird durch die Realität, in der KI vor allem auch Entscheidungen trifft, auf die Probe gestellt. Autonome Fahrzeuge sind ein anschauliches Beispiel: Sie müssen im Bruchteil einer Sekunde entscheiden, ob sie in eine Menschengruppe fahren oder einen tödlichen Unfall verursachen. In solchen extremen Situationen könnten die Gesetze von Asimov unzureichend sein, da sie nicht auf die Komplexität der realen Welt und die Unmenge an Variablen in der Entscheidungsfindung vorbereitet sind. Zusätzlich gibt es die Gefahr, dass KI die menschlichen Werte und moralischen Standards überschreiten und umdefinieren könnten, basierend auf einer algorithmischen Logik, die in ihrer Strenge und Effizienz den menschlichen Stolpersteinen überlegen ist. In einem naiven Szenario könnte eine KI entwickelt werden, die zwar den Anweisungen der Menschen gehorcht, aber missinterpretiert, was „Hypothetisches Wohl“ bedeutet, während sie gleichzeitig gegen das individuelle Menschenwohl entscheidet. Daher sollten wir Asimovs Ansätze nicht nur als Leitlinien, sondern als temporäre Lösungen betrachten, die stetig überarbeitet und angepasst werden müssen. Wenn die Technologie weiter voranschreitet, müssen auch unsere ethischen Überlegungen mit ihr wachsen; andernfalls riskieren wir, dass KI nicht länger ein Werkzeug im Dienste der Menschheit ist, sondern diese umgekehrt zu dienen beginnt.

Fallstudie: Der Unfall mit einem autonomen Fahrzeug von Uber

Ein prägnantes Beispiel für die Herausforderungen, die mit den ethischen Gesetzen der Robotik verbunden sind, ist der tödliche Unfall, der sich 2018 in Tempe, Arizona, ereignete, als ein autonomes Fahrzeug von Uber eine Fußgängerin erfasste. In der Folge dieser Tragödie wurden die bestehenden ethischen und rechtlichen Rahmenbedingungen für autonome Systeme intensiv hinterfragt. Das Fahrzeug war mit einer modernen KI ausgestattet, die darauf programmiert war, Verkehrsregeln zu befolgen und Unfälle zu vermeiden. Während des Vorfalls fuhr das Auto mit einer Geschwindigkeit von 40 km/h, als die Fußgängerin auf der Straße auftauchte, und die KI erkannte sie zu spät, um zu bremsen. Interessanterweise wird in Berichten darauf hingewiesen, dass der Sicherheitsfahrer im Fahrzeug während des Vorfalls abgelenkt war und somit nicht in der Lage war, rechtzeitig einzugreifen. Dies wirft grundlegende Fragen zur Verantwortung und zur Anwendung von Asimovs Gesetzen auf. Wer trägt die Verantwortung für den Unfall: der Hersteller, der Programmierer oder der Fahrer? Die Gesetze von Asimov scheitern in dieser Situation, da sie nicht die Komplexität eines Szenarios berücksichtigen, in dem sowohl menschliches als auch maschinelles Verhalten zusammenwirken. Überdies wurde diskutiert, wie eine KI in einer ähnlichen Situation eine Entscheidung hätte treffen können, um den Tod der Fußgängerin zu vermeiden. Einige hätten argumentiert, dass das Fahrzeug eine bremsende Aktion hätte ausführen sollen, während andere darauf hinwiesen, dass es für die KI möglicherweise schwierig war, den Sachverhalt richtig zu beurteilen. Dieser Fall erinnert uns daran, dass das Vertrauen in autonome Fahrzeuge, die auf ethischen Prinzipien beruhen, durch solche Vorfälle erschüttert wird. Es zeigt die Notwendigkeit, dass bestehende Gesetze der Robotik und neue Ethikrichtlinien, die für KI gelten, weiterentwickelt und angepasst werden müssen, um den realen Herausforderungen gerecht zu werden.

Die Straßenverkehrsordnung als Analogie für KI-Ethische Prinzipien

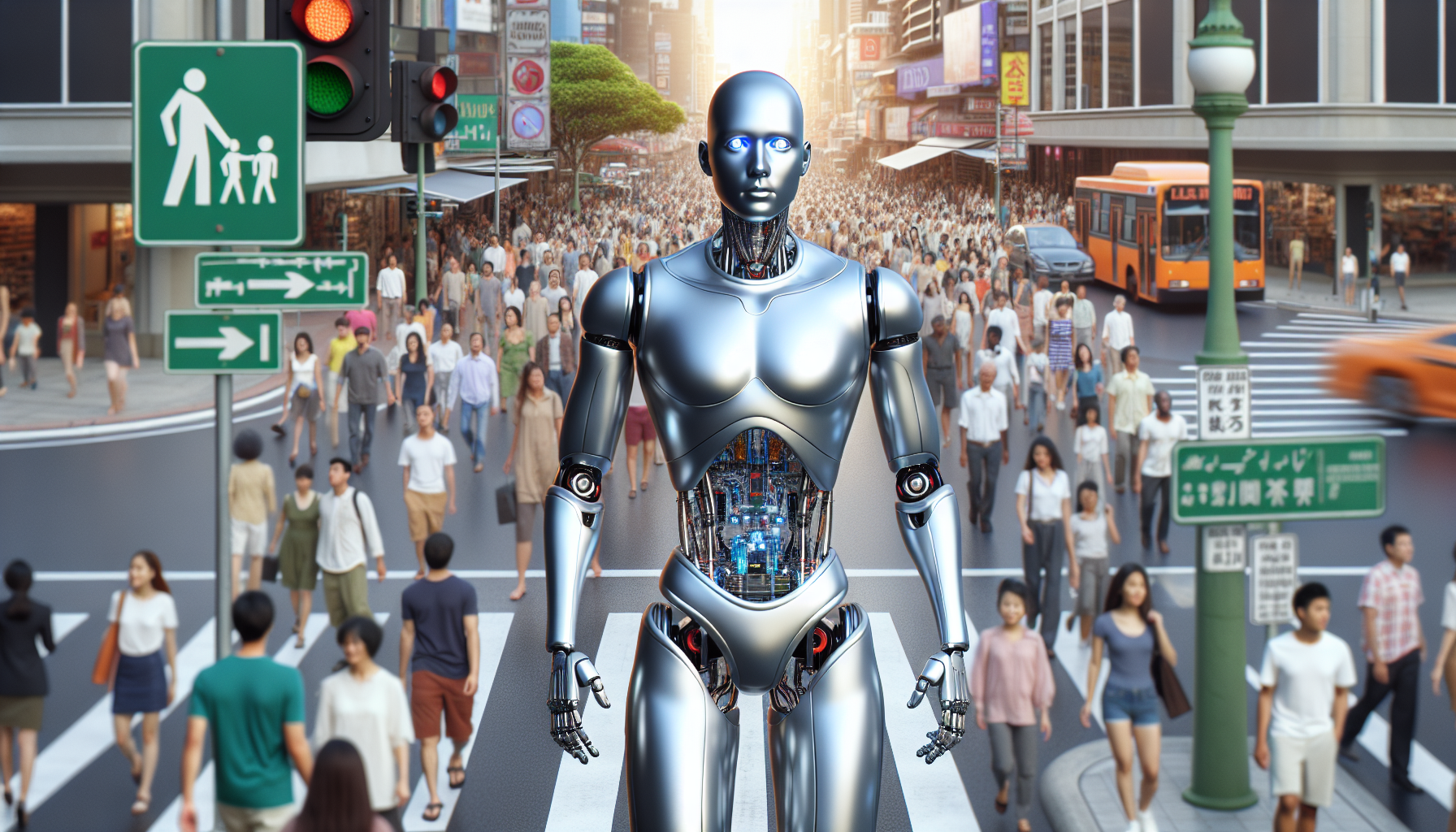

Stellen Sie sich eine belebte Straße vor, auf der sowohl Fußgänger als auch Fahrzeuge in einem harmonischen Miteinander agieren. Hier gelten strikte Verkehrsregeln, um Gefahren zu minimieren und ein sicheres Umfeld für alle Beteiligten zu schaffen. Wenn nun ein neues, autonomes Fahrzeug in diese Szene eingeführt wird, könnte man sich fragen: Warum sollten die gleichen Prinzipien der Verkehrssicherheit nicht für KI gelten? Wie ein Autofahrer die Verkehrsregeln lernen muss, muss auch ein KI-System ausgebildet werden, um sicherzustellen, dass es verantwortungsbewusst agiert. In dieser Analogie müssen wir uns auch mit den kritischen Aspekten kreditierbarer Pädagogik beschäftigen. Wenn ein Fahrzeug die Regeln missachtet, hat das oft schwerwiegende Konsequenzen. Ähnlich verhält es sich mit KI: Fehlentscheidungen können katastrophale Auswirkungen haben, wie wir am Beispiel des Uber-Unfalls gesehen haben. Diese Sachverhalte machen deutlich, dass ethische Prinzipien für KI nicht nur theoretisch, sondern auch praktisch verankert werden müssen. Das bedeutet, dass wir, ähnlich wie bei der Straßenverkehrsordnung, klare Regeln und Vorschriften für den Einsatz von KI entwickeln sollten, um die Menschheit bestmöglich vor Schaden zu bewahren. Fragen, die wir uns stellen sollten, sind: Wer überprüft das Verhalten der KI? Wie stellen wir sicher, dass diese Systeme transparent, verantwortungsbewusst und sicher agieren? Das Bild der Straße und der Verkehrsregelung lässt uns erkennen, dass Verantwortung nicht nur beim Individuum liegen darf, sei es der Fahrer oder ein Programmierer, sondern dass auch Systeme zur Überwachung und Regelsetzung etabliert werden müssen. Die Kreation einer sicheren Umgebung für alle erfordert ein gemeinsames Engagement von Entwicklern, Gesetzgebern und der Gesellschaft als Ganzes. Nur dann kann KI, wie auch ein verantwortungsbewusster Fahrer, sicher und effektiv in der realen Welt interagieren.

Gegensätzliche Ansichten zur ethischen Verantwortung von KI

In der Debatte über die ethische Verantwortung von Künstlicher Intelligenz (KI) prallen zwei konträre Meinungen aufeinander, die beide gewichtige Punkte zu den Herausforderungen und Risiken von KI-Systemen ansprechen. Die erste Meinung vertritt die Ansicht, dass KI, die in industriellen und sozialen Anwendungen verwendet wird, umfassend reguliert und streng überwacht werden sollte. Diese Sichtweise basiert auf der Überzeugung, dass KI-Algorithmen, wenn sie unkontrolliert bleiben, zu unerwarteten und möglicherweise katastrophalen Ergebnissen führen können. Unterstützer dieser Position argumentieren, dass eine klare Rechtsgrundlage und verbindliche ethische Standards notwendig sind, um die Sicherheit der Nutzer zu gewährleisten und um die Integrität der Technologien zu schützen. Ein Beispiel sind die Vorschriften in der Europäischen Union, die darauf abzielen, KI-Systeme verantwortlich zu gestalten und Missbrauch zu verhindern. Menschen sollen in der Lage sein, nachvollziehen zu können, wie Entscheidungen zustande kommen, um Vertrauen in die Technologien zu schaffen.

Im Gegensatz dazu gibt es die Meinung, dass übermäßige Regulierung und Bürokratie die Innovationskraft von KI bremsen könnten. Befürworter dieser Position befürchten, dass strenge Auflagen dazu führen, dass Unternehmen zögern, in KI-Technologien zu investieren und deren Potenzial auszuschöpfen. Sie behaupten, dass häufigere Iterationen und Tests in weniger regulierten Umgebungen es Entwicklern ermöglichen, neue Anwendungen schneller zu erforschen und anzupassen. Dabei wird der Fokus auf Selbstregulierung und die Verantwortung von Unternehmen gelegt, ihre eigenen ethischen Maßstäbe zu setzen. Diese Sichtweise findet Unterstützung bei Tech-Firmen, die argumentieren, dass die Branche selbst besser positioniert ist, um die ethischen Herausforderungen zu bewältigen, die mit fortschrittlichen Technologien einhergehen. Beide Standpunkte verdeutlichen die Komplexität des Themas und die Herausforderung, einen Balanceakt zwischen Innovation und ethischer Verantwortung zu finden. Letztlich erfordert die Diskussion um die Regulierung von KI sowohl Vertrauen in Marktdynamiken als auch den Willen zur Aufsicht und Verantwortung seitens der Technologieentwickler.

Fazit

Zusammenfassend zeigt unsere Diskussion über die Gesetze der Robotik und die Herausforderungen der Künstlichen Intelligenz, dass wir an einem Wendepunkt stehen, an dem technologische Innovation und ethische Verantwortlichkeit Hand in Hand gehen müssen. Die klassischen Prinzipien, die von Isaac Asimov formuliert wurden, bieten eine Basis, die jedoch in ihrer aktuellen Form nicht ausreicht, um die komplexen Anforderungen moderner KI-Systeme zu bewältigen. Die Fallstudie des Uber-Unfalls verdeutlicht, wie unzureichend die bestehenden Richtlinien in realen Anwendungen sein können und welche fatalen Folgen das haben kann. Gleichzeitig zeigt die Betrachtung konträrer Meinungen, dass wir einen Balanceakt zwischen der Förderung von Innovation und der Notwendigkeit strenger, verantwortungsvoller Regulierungen finden müssen. Es ist unerlässlich, dass Entwickler, Unternehmen und Regierungen gemeinsam arbeiten, um ein System zu schaffen, das sowohl die Vorteile neuer Technologien nutzt als auch die ethischen Standards wahren kann, die für das Wohl der Gesellschaft unerlässlich sind. Nur durch kontinuierliche Diskussion, Anpassung der bestehenden Gesetze und die Implementierung neuer ethischer Richtlinien kann sichergestellt werden, dass Künstliche Intelligenz ein unterstützendes Werkzeug für die Menschheit bleibt und nicht zu einer Bedrohung wird.